Aprende Apache Kafka desde cero: arquitectura, producers, consumers y casos de uso reales de data streaming en entornos empresariales.

Introducción

El Curso de Apache Kafka para Data Streaming está diseñado para profesionales de datos, desarrolladores y perfiles técnicos que desean comprender y aplicar Kafka como plataforma de streaming distribuido en entornos reales. A lo largo del curso aprenderás los fundamentos de Kafka, su arquitectura interna, el funcionamiento de producers y consumers, y cómo implementar soluciones de streaming de datos escalables, tolerantes a fallos y de alto rendimiento.

El enfoque es práctico y progresivo, combinando conceptos clave con ejemplos reales y casos de uso empresariales en Big Data, analítica en tiempo real e integración de sistemas.

Objetivos del Curso

- Comprender los fundamentos del data streaming y el rol de Apache Kafka

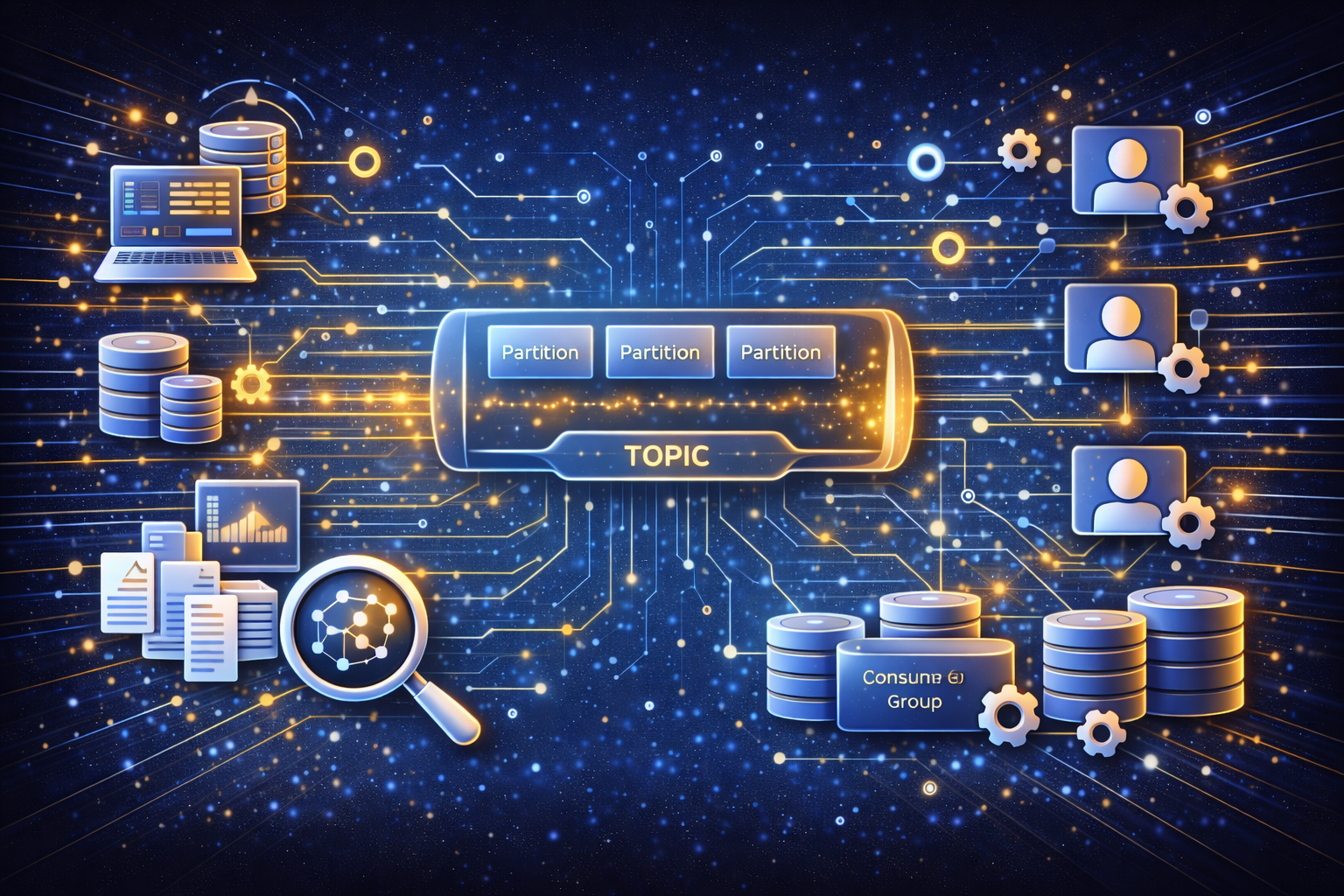

- Conocer la arquitectura interna de Kafka y sus componentes clave

- Crear y configurar producers y consumers

- Gestionar topics, partitions y offsets

- Implementar patrones comunes de consumo y producción de eventos

- Aplicar Kafka en casos de uso reales de negocio

Metodología:

Formación totalmente práctica, combinando breves explicaciones teóricas con laboratorios y ejercicios guiados en entornos reales.

El curso se imparte en modalidad online en directo, utilizando contenedores Docker para desplegar un clúster funcional de Kafka y practicar todas las operaciones.

Los participantes desarrollarán ejercicios sobre casos de uso reales: monitorización de datos, integración con bases de datos y procesamiento en streaming.

Temario:

| Módulo | Nombre del Módulo | Contenidos |

|---|---|---|

| Módulo 1 | Introducción al Data Streaming |

|

| Módulo 2 | Arquitectura de Apache Kafka |

|

| Módulo 3 | Topics y Gestión de Mensajes |

|

| Módulo 4 | Kafka Producers |

|

| Módulo 5 | Kafka Consumers |

|

| Módulo 6 | Casos de Uso con Apache Kafka |

|

| Módulo 7 | Buenas Prácticas en Producción |

|

¿A quién va dirigido?

El Curso de Apache Kafka para Data Streaming está dirigido a profesionales técnicos y perfiles de negocio que necesitan trabajar con datos en tiempo real y arquitecturas basadas en eventos:

- Data Engineers y Big Data Engineers

- Desarrolladores Backend y Full Stack

- Arquitectos de Software y Arquitectos de Datos

- Analistas de Datos con foco en streaming

- Equipos de IT, innovación y transformación digital

- Profesionales que quieran iniciarse en Apache Kafka desde una base sólida

Beneficios del Curso

Al realizar el Curso de Apache Kafka para Data Streaming, obtendrás beneficios claros y aplicables a entornos profesionales:

- Comprensión completa de Apache Kafka y su ecosistema

- Capacidad para diseñar soluciones de data streaming escalables

- Dominio del uso de producers y consumers

- Mejora en la integración de sistemas y microservicios

- Conocimientos aplicables a proyectos reales de Big Data

- Perfil técnico más competitivo en el mercado laboral

Aplicación Práctica: ¿Qué Podrás Hacer en tu Día a Día?

Tras completar el Curso de Apache Kafka para Data Streaming, podrás aplicar el conocimiento de forma directa en tu trabajo diario:

- Diseñar pipelines de datos en tiempo real con Apache Kafka

- Publicar y consumir eventos usando Kafka Producers y Consumers

- Integrar microservicios mediante arquitecturas event-driven

- Procesar grandes volúmenes de datos con baja latencia

- Implementar sistemas de monitorización y logging en tiempo real

- Optimizar la comunicación entre aplicaciones distribuidas

Salidas Profesionales (Perfiles y Roles)

La formación en Apache Kafka para Data Streaming te prepara para acceder o evolucionar hacia roles altamente demandados:

- Data Engineer

- Big Data Engineer

- Backend Developer

- Software Architect

- Data Architect

- Especialista en Data Streaming

- Ingeniero de Integración de Sistemas

FAQ – Preguntas Frecuentes sobre el Curso de Apache Kafka para Data Streaming

- ¿Necesito experiencia previa en Apache Kafka?

No. El Curso de Apache Kafka para Data Streaming comienza desde los fundamentos y avanza de forma progresiva hasta un nivel intermedio.

- ¿Es un curso teórico o práctico?

El curso combina teoría esencial con ejemplos prácticos y casos de uso reales aplicables a entornos empresariales.

- ¿Qué aprenderé exactamente sobre Kafka?

Aprenderás la arquitectura de Apache Kafka, el uso de topics, partitions, producers, consumers y su aplicación en escenarios reales de data streaming.

- ¿Este curso es útil para Big Data?

Sí. Apache Kafka es una tecnología clave en ecosistemas Big Data y el curso está orientado a su uso en pipelines de datos y arquitecturas modernas.

- ¿Qué salidas laborales tiene Apache Kafka?

Apache Kafka es muy demandado en perfiles de Data Engineer, Big Data Engineer y arquitectos de sistemas distribuidos, lo que convierte este curso en una formación con alta empleabilidad.

- ¿El curso es adecuado para empresas?

Sí. El Curso de Apache Kafka para Data Streaming está diseñado tanto para formación individual como para capacitación de equipos técnicos en entornos corporativos.